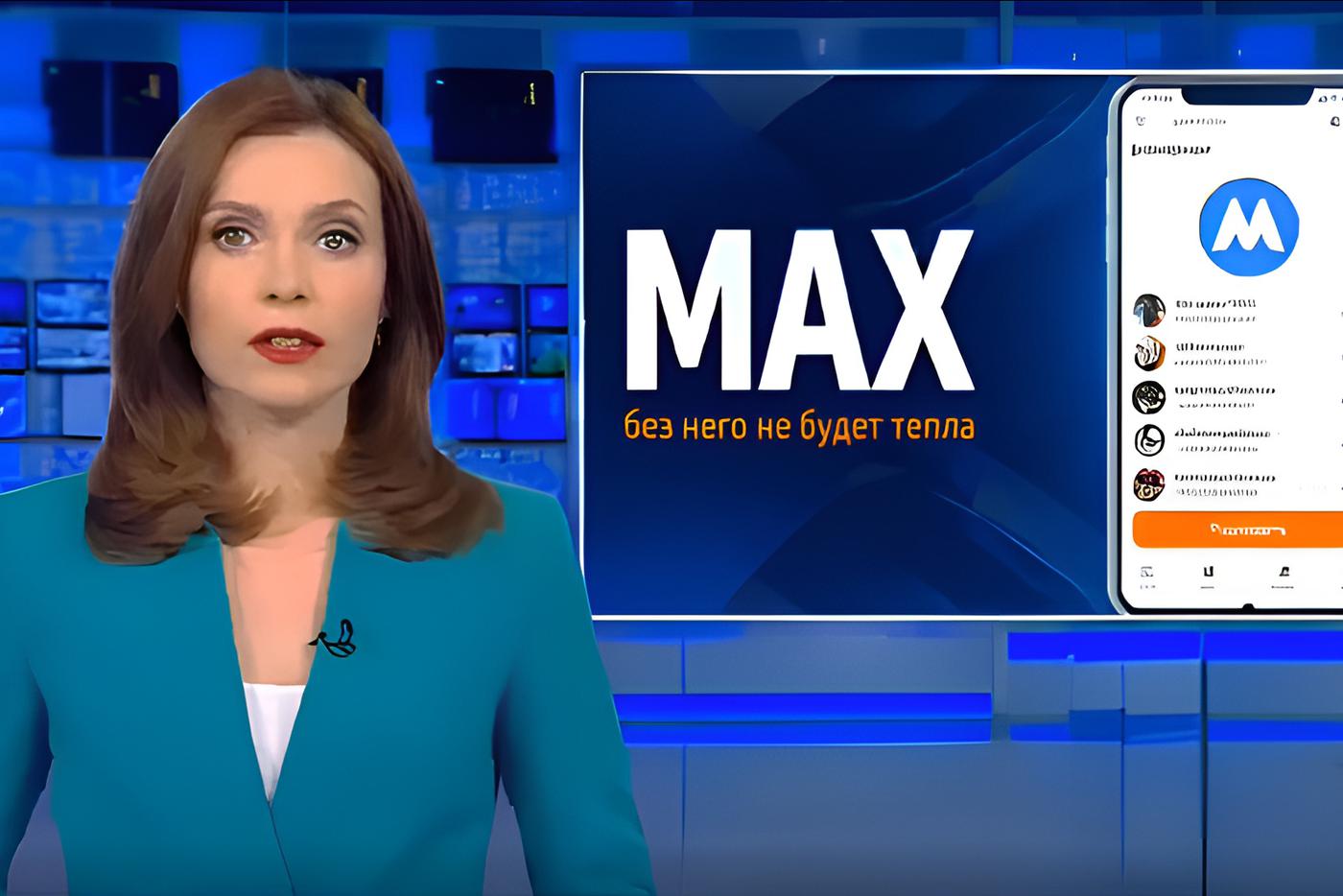

Компания OpenAI, подарившая миру ChatGPT, представила новую модель для генерации видео пользователями – Sora 2 в конце сентября. После этого Сеть наполнилась множеством различных видео, созданных нейросетью, которые на первый взгляд крайне сложно отличить от реальных съёмок. Так, некоторые пользователи даже попытались в ироничном ключе прорекламировать национальный мессенджер Max, придумав про него ролик в стиле выпуска новостей.

Также в Сети стали помещать главу компании и разработчика нейросети Сэма Альтмана в комичные ситуации. При этом возможности Sora 2 поражают. Ведь она позволяет генерировать контент, который не подлежит модерации. Таким образом пользователи уже создали "рекламу" острова педофила Джеффри Эпштейна в стиле детского видео из 90-х.

При этом в разговоре с Metro ведущий аналитик Mobile Research Group Эльдар Муртазин подтвердил, что нейросети становятся у пользователей всё популярнее. Однако до полного фотореализма им пока далеко.

– Новая модель Sora 2 даёт очень реалистичные, хорошие материалы. Но они пока хорошо отличимы от реальных видео. В то же время надо понимать простую вещь – рано или поздно, через 2–3 года, появятся нейросети, которые действительно научатся налету создавать дипфейки, неотличимые от реальных видео. И в этом плане нам нужно выработать очень понятные и простые критерии, по которым такие материалы будут отличаться, чтобы пользователей не могли обмануть, – пояснил эксперт.

Он также подчеркнул, что законодатели уже работают в этом направлении – как минимум на уровне разработки специальной маркировки для сгенерированного контента.

– Обычные люди тоже пытаются в этой теме разобраться. Но, скорее всего, мы "переболеем" дипфейками и потом уже научимся их отличать от реальных видео или перестанем реагировать на то, что кто-то что-то сказал, из-за изобилия такого контента, – оптимистично заметил Муртазин.